高通主打分解式推理 劍指輝達Rubin CPX

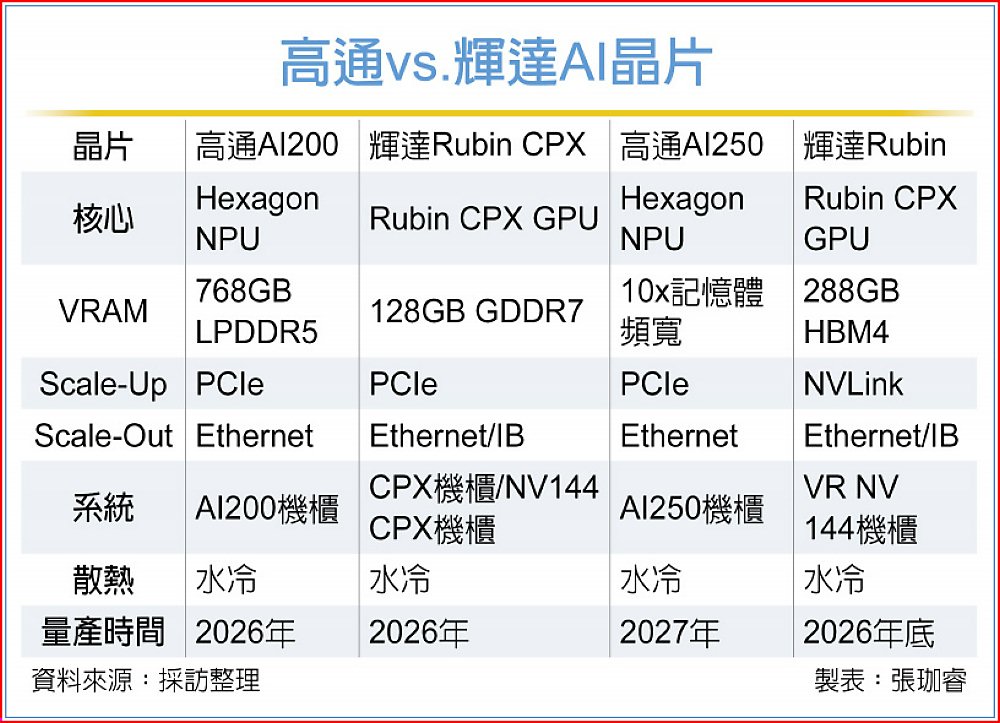

高通(Qualcomm)正式重返AI晶片戰場,宣布推出全新Cloud AI200與AI250推理加速卡,聚焦資料中心的推理運算市場。主打Disaggregated Inferencing(分解式推理)架構,瞄準輝達Rubin CPX系列。

供應鏈透露,高通前一代Cloud AI 100已賦能台廠智慧製造升級,並採用台積電7奈米製程打造,Cloud AI200以Hexagon NPU為核心,推估以台積電3奈米製程打造最具效率。

高通非AI晶片新兵,AI 100自2019年推出,2024年持續推出更新版本AI 100 Ultra,規格達870 TOPS、128GB LPDDR4,並獲得台廠採用、進行智慧製造升級;如日月光使用其AI 100加速器,將AI帶入製造現場,分析即時影像資料、達到維修與製程監控目的。

AI200以及AI250兩款皆採用液冷的技術,基於驍龍Hexagon NPU(神經處理單元)為基礎設計。供應鏈指出,AI 100為台積電7奈米製程助攻,AI200推測將持續採用台積電先進製程,在投片效率及成本衡量下,將會與今年的高階手機晶片同採3奈米製程,透過過往手機晶片經驗積累,高通發展AI晶片具備高效能、低功耗優勢。

分解式推理是指將AI模型的前置(Prefill)與解碼(Decode)過程分離,透過分工架構提升整體運算效能;繼輝達宣布推出Rubin CPX系列後,高通AI200/250的揭露,意謂新一代AI伺服器設計架構主流成形。

AI200搭載768GB LPDDR5記憶體,數量優於輝達Rubin CPX的128GB GDDR7;而AI250聚焦「Decoder」階段,採用近存計算(Near-Memory Computing) 架構,使記憶體頻寬提升達10倍,相當於HBM4等級效能;業者分析,AI250若使用HBM則將採用台積電CoWoS先進封裝打造。

隨著大型CSP與企業紛紛導入AI推理集群,高通瞄準分解式推理晶片,被視為重返AI雲端舞台的關鍵一步。市場研究機構指出,若AI200/250能順利量產並獲雲端服務商採用,高通將從行動處理器供應商轉型為AI運算平台供應商,挑戰輝達地位。